EIF rapport met randvoorwaarden voor "Fair AI" voor microkrediet

Onderzoekers van EIF hebben een model ontwikkeld met 5 stappen om binnen AI-systemener voor te zorgen dat iedereen zo gelijk mogelijk wordt behandeld bij financieringsaanvragen. Als case study wordt een analyse gemaakt van het AI model van Qredits.

Onderzoekers van EIF hebben een model ontwikkeld om "eerlijkheid" in AI-gebaseerde kredietbeoordelingssystemen te beoordelen en te verbeteren. Er worden 3 bestaande modellen van "Fair AI" gebruikt om te komen tot een nieuw model voor het ontwikkelen van een zo inclusief mogelijk model binnen de gehele levenscyclus van AI-sytemen.

Verbeteren efficiëntie in inclusieve financiële sector

Het rapport is de eerste publicatie dat voortkomt uit het project "Strengthening Financial Inclusion through Digitalisation" (SFIDE), dat gefinancierd wordt door het EIB Institute en gericht is op het onderzoeken van de mogelijkheden om de efficiëntie van de inclusieve financiële sector te vergroten.

Huidige framework modellen

In het rapport worden in eerste instantie een aantal huidige frameworks besproken:

De UNESCO Recommendation on the Ethics of Artificial Intelligence waarin ingegaan wordt op:

- AI moet voor iedereen toegankelijk zijn

- Ontwikkelaars van AI systemen moeten er voor zorgen dat systemen niet "biased" zijn, inclusief oplossingen om eventuele voorkeuren te repareren/aan te passen wanneer die gevonden worden

- Kennisverschillen moeten worden opgelost, zodat elke persoon rechtvaardig wordt behandeld.

Een beetje open deuren, maar een goede basis voor "Fair AI".

Het AI Blindspot model van MIT gaat een stap verder. Het model is ontwikkeld om onbedoelde uitkomsten van AI-systemen te vinden. Om blinde vlekken te vermijden worden een reeks stappen voorgesteld voor de ontwikkeling en het gebruik van AI-systemen: Planning, bouwen, implementeren en monitoren.

- In de planningsfase moet de maker van het AI-systeem nadenken over het doel van het systeem, hoe representatief de gegevens zijn, of en hoe het kan worden misbruikt en hoe privacy kan worden gewaarborgd.

- In de bouwfase moet het optimalisatiecriterium worden ingesteld. Dit is erg belangrijk voor een AI-systeem, omdat het systeem probeert om elke indicator die deel uitmaakt van het optimalisatiecriterium te verbeteren en alle andere negeert. In dezelfde stap moet de begrijpelijkheid van het AI-systeem worden verduidelijkt.

- In de implementatiefase moeten de makers een systeem opzetten om de AI te monitoren en te reageren op eventuele veranderingen die in de loop van de tijd kunnen optreden, en individuen het recht bieden om bezwaar te maken.

- De laatste fase gaat over het monitoren van de AI en het regelmatig bespreken met experts om ervoor te zorgen dat het AI-systeem nog steeds hetzelfde doel dient als waar het mee begonnen is.

Deze 4 stappen zorgen er voor dat er in alle fases van de ontwikkeling van AI-modellen feedback loops ontstaan, waarin ongewenste uitkomsten gecorrigeerd kunnen worden.

Als laatste is er gebruik gemaakt van het Policy Guidance on AI for Children model van UNICEF. Dit model is ontwikkeld voor AI-systemen die gericht zijn op of gebruikt worden door kinderen.

Rond "Fairness" gaat het hierbij om twee onderdelen:

- Ten eerste moeten AI-systemen actief de meest gemarginaliseerde kinderen ondersteunen om gelijke toegang te bieden.

- Ten tweede moeten datasets representatieve gegevens van alle kinderen bevatten, vooral in de gezondheidszorg. De behandeling van kinderen moet gebaseerd zijn op representatieve gegevens uit hun leeftijdsgroep. Daarnaast moeten beperkingen in representativiteit altijd expliciet worden vermeld.

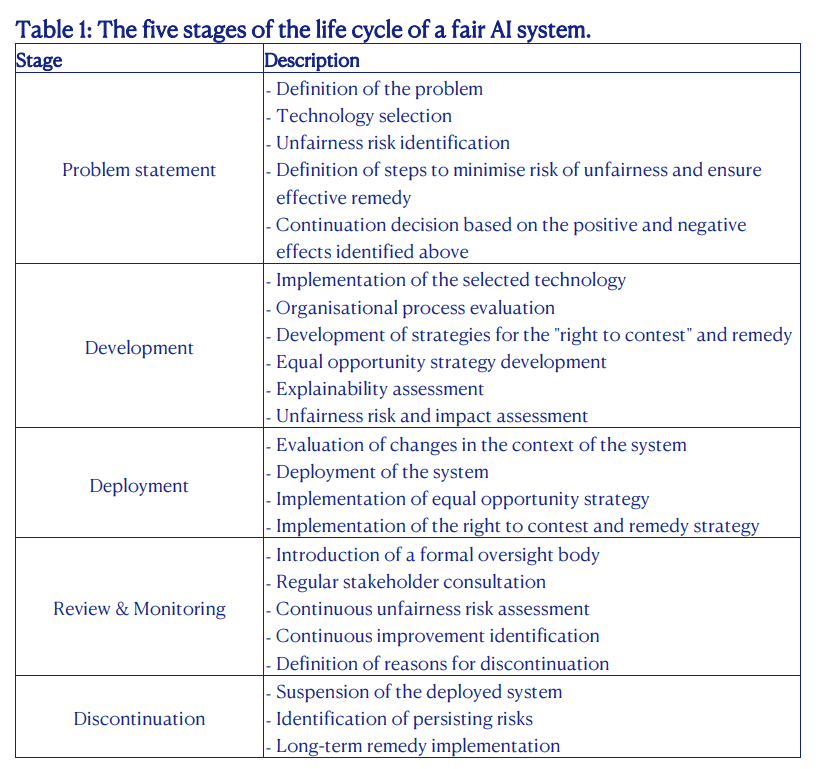

Framework voor de levenscyclus van AI systemen

Uiteindelijk komen de onderzoekers tot een model waarin de 5 fases van een AI systeem worden besproken, waarbij er rekening wordt gehouden met goede representativiteit en wat de belangrijkste uitdagingen zijn in elke fase:

Qredits

Als case study is het model getest op de AI modellen die in gebruik zijn door Qredits. In sommige gevallen worden daar tot 1200 datapunten geanalyseerd, blijkt uit het onderzoek. Belangrijk hierbij is efficiëntie en kostenreductie. Toch blijft de menselijke maat ook belangrijk en daarom wordt AI daar vooral ondersteunend ingezet door Qredits.

De specifieke aandachtspunten en aanbevelingen komen niet in detail in het rapport terug. Wel dat er suggesties zijn rond het meer transparant en inzichtelijk maken aan stakeholders van het algoritme dat wordt gebruikt (is nu een "black box") en een meer gestandaardiseerd proces rond klachten wanneer er mogelijk onterechte afwijzingen plaatsvinden.

Hoewel het vooral een wetenschappelijke exercitie is, is dit wel weer een goede stap om als Fintech sector er in de verschillende fases van de ontwikkeling en het afbouwen van AI-systemen er voor te zorgen dat iedereen gelijk behandeld wordt in financieringsaanvragen.

Download rapport: EIF Working Paper 2023/88, Fairness in algorithmic decision systems: a microfinance perspective

Comments ()